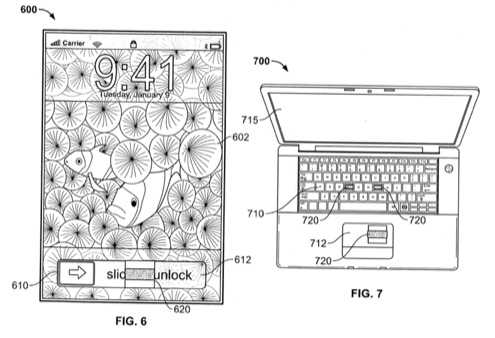

Diciamocelo chiaramente: non è proprio una grande novità, ma nuove informazioni da brevetti Apple sembrano confermare quello che molti aspettano da tempo, ovvero l’approdo di Siri anche su Mac.

Apple non ha mai rivelato quale tecnologia sia alla base del riconoscimento vocale che permette a Siri di interpretare l’input degli utenti.

C’era più di un velato sospetto, tuttavia, che potesse essere Nuance, azienda leader nel mercato della sintesi vocale, a fornire i servizi e il know-how necessario all’azienda di Cupertino, ma nessuno aveva mai potuto confermare le indiscrezioni.

Fino ad oggi, almeno, visto che proprio il CEO di Nuance, Paul Ricci, ha rivelato la partnership fra Apple e la sua compagnia durante un’intervista alla D11 Conference.

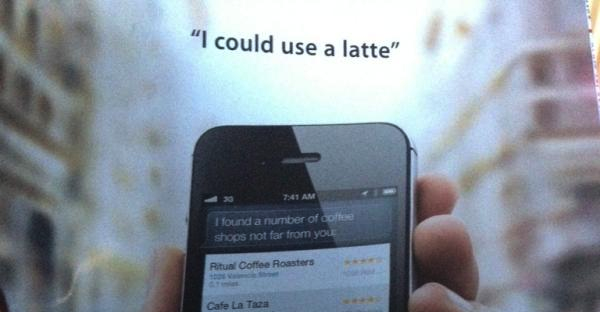

Siri è senza dubbio la feature più sponsorizzata di iPhone 4S. Non stupisce quindi vedere in televisione spot in cui Babbo Natale usa il telefono di Cupertino per organizzare la consegna dei regali. Quello che non siamo abituati a vedere è invece una pubblicità di Apple su carta stampata, con protagonista proprio Siri.

Siri è senza dubbio la feature più sponsorizzata di iPhone 4S. Non stupisce quindi vedere in televisione spot in cui Babbo Natale usa il telefono di Cupertino per organizzare la consegna dei regali. Quello che non siamo abituati a vedere è invece una pubblicità di Apple su carta stampata, con protagonista proprio Siri.

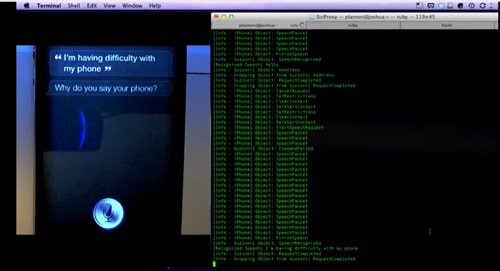

A metà del mese scorso Applidium ha completato il processo di reverse engineering del protocollo utilizzato da Siri per comunicare con i server Apple. Sulla base di quel risultato @Plamoni è riuscito a creare un Proxy Server che può essere interfacciato con Siri su rete locale e permette di ampliare le potenzialità dell’assistente vocale integrato su iPhone 4S.

Un esempio di quello che è possibile fare con il Proxy Server di Plamoni ve lo abbiamo mostrato la scorsa settimana, con il video dello smanettone che ha trovato il modo di accendere e spegnere la macchina tramite Siri.

Il sito SiriHacks, nato appositamente per raccogliere questo tipo di materiale, è una buona base di partenza per scoprire quali altri smanettamenti sono stati completati grazie a script sviluppati appositamente per il ProxyServer di Plamoni. Di seguito alcuni dei più interessanti.

Apple ci sta riuscendo ancora una volta, ammettiamolo: prima del 4 ottobre non ci interessavamo più di tanto del riconoscimento vocale. Si, certo, se ne parlava. C’erano prodotti interessanti e Nuance era già un nome noto del settore, i suoi software un successo in tutto il mondo. Ma è con Siri e l’iPhone 4S che abbiamo cominciato a guardare in maniera diversa alle tecnologie di riconoscimento vocale. E’ l’innovazione, aiutata dalla rassicurante ed efficace macchina del marketing di Cupertino.

Apple ci sta riuscendo ancora una volta, ammettiamolo: prima del 4 ottobre non ci interessavamo più di tanto del riconoscimento vocale. Si, certo, se ne parlava. C’erano prodotti interessanti e Nuance era già un nome noto del settore, i suoi software un successo in tutto il mondo. Ma è con Siri e l’iPhone 4S che abbiamo cominciato a guardare in maniera diversa alle tecnologie di riconoscimento vocale. E’ l’innovazione, aiutata dalla rassicurante ed efficace macchina del marketing di Cupertino.

Sta di fatto che ormai siamo sommersi da notizie e spunti interessanti su Siri e sui fondatori della startup acquisita da Apple, nonché su altri particolari dell’assistente virtuale di iPhone 4S, come il fatto che la voce britannica maschile sia di un attore che l’ha prestata alla macchina… cinque anni fa.

Nelle ultime due settimane mi sono trovato ad utilizzare sempre più spesso la funzione di riconoscimento vocale del mio iPhone 4. Sarà un po’ l’invidia per Siri e per l’iPhone 4S, sarà perché ormai quando sono alla scrivania il mio iPhone è perennemente connesso all’Hi-Ring, fatto sta che mi trovo a pronunciare “chiama tizio” e “chiama caio” con notevole frequenza.

Nelle ultime due settimane mi sono trovato ad utilizzare sempre più spesso la funzione di riconoscimento vocale del mio iPhone 4. Sarà un po’ l’invidia per Siri e per l’iPhone 4S, sarà perché ormai quando sono alla scrivania il mio iPhone è perennemente connesso all’Hi-Ring, fatto sta che mi trovo a pronunciare “chiama tizio” e “chiama caio” con notevole frequenza.

Ora scopro tramite Shawn Blanc (via Gruber) che già da un paio di generazioni iOS permette di specificare per ogni contatto un nome e un cognome fonetico. Vale a dire, in poche parole, che se un vostro amico si chiama George Clooney potrete suggerire al riconoscimento vocale¹ del vostro dispositivo di pronunciarlo come Sgiòrsg Clunei.

Dopo un keynote ricco di novità ma privo del carisma di Jobs (che sarebbe riuscito a rendere affascinante anche iCards), finalmente Apple ha tirato fuori la vera sorpresa: Siri.

Non che si tratti di una novità vera e propria, del resto i rumors si sono rivelati piuttosto esatti al riguardo (compreso un inquietante mockup di MacRumors pressoché identico), ma finalmente abbiamo tra le mani qualcosa che segna di nuovo il sorpasso di Apple sui propri concorrenti. Immaginate di poter parlare con il vostro iPhone in maniera assolutamente naturale e di ricevere, in cambio, azioni e risultati pertinenti.

Cercate un ristorante in zona? Volete impostare la sveglia per domattina? Volete sapere quanti giorni mancano a Natale? Chiedete a Siri.

Sabato scorso Apple ha distribuito agli sviluppatori la quinta versione Beta di iOS 5, assieme alla nuova versione beta di iTunes, Xcode e dell’update del software di Apple TV.

La nuova versione beta di iTunes è necessaria per poter aggiornare i dispositivi di test direttamente dal Mac, ma gli sviluppatori hanno anche la possibilità di eseguire la procedura direttamente dai device, grazie alla nuova funzione di update over the air che ha debuttato un paio di settimane fa con la release della quarta beta del sistema operativo mobile.

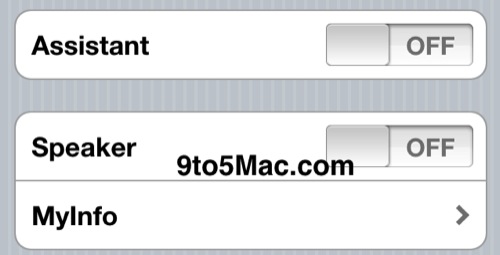

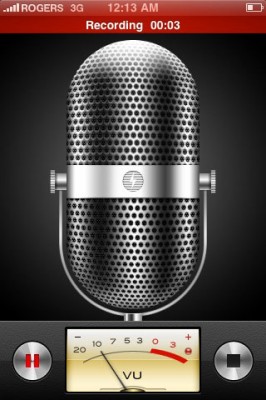

Le novità di iOS Beta 5 non sono poche, come mostra il changelog completo riportato da CultOfMac, anche se la scoperta più interessante, che riguarda il riconoscimento vocale, non è annotata né visibile di default.

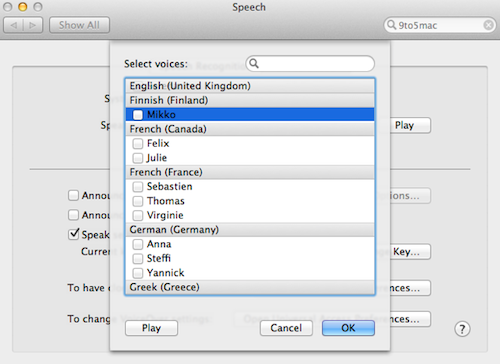

Ricordate la prima presentazione del Macintosh? Era il 1984, io non ero neanche nato, ma l’ho vista su youtube. Un giovane Steve Jobs sconvolge ed emoziona un’intera platea dopo aver mostrato loro il primo personal computer parlante. Standing ovation e lacrime di gioia. Tutto molto bello, ma ovviamente anche tutto in inglese. I Mac parlano, sì, da 27 anni. Ma solo in inglese.

E chi non conosce l’inglese? “Se lo impara”. Questa era la risposta fino a Snow Leopard, a meno di non acquistare programmi esterni ovviamente. Ma le cose con OS X Lion cambiano: il leone è poliglotta, vediamo in questo post come farlo ruggire in tutte (o quasi) le lingue del mondo, compresa l’italiano.

Nel 1987 Apple pubblicò un concept-video in cui descriveva con dovizia di particolari “cinematografici” un oggetto elettronico noto come Knowledge Navigator. Una specie di iPad da scrivania in grado di interpretare le richieste dell’utente e restituire ricerche e informazioni dettagliate su qualsiasi argomento. Da alcuni dialoghi fra il dispositivo e il “professore” che lo utilizza si capisce che quel video era ambientato nel 2011.

Nel 1987 Apple pubblicò un concept-video in cui descriveva con dovizia di particolari “cinematografici” un oggetto elettronico noto come Knowledge Navigator. Una specie di iPad da scrivania in grado di interpretare le richieste dell’utente e restituire ricerche e informazioni dettagliate su qualsiasi argomento. Da alcuni dialoghi fra il dispositivo e il “professore” che lo utilizza si capisce che quel video era ambientato nel 2011.

Ad oggi abbiamo fra le mani qualcosa di simile a quel concept, ovvero l’iPad, ma le funzioni di assistente virtuale ancora non si sono evolute fino a quel livello. Qualcosa potrebbe cambiare con “Assistant”, una nuova funzione basata sulla tecnologia di Siri (azienda acquisita da Apple nell’aprile del 2010).

Diverse sono state le feature anticipate dai rumors in rete che hanno trovato conferma durante il keynote di apertura della WWDC lunedì scorso. L’integrazione con Twitter, ad esempio, o un nuovo sistema di notifiche, che abbiamo scoperto dalla presentazione di Forstall chiamarsi Notification Center. iOS 5 introduce molte novità, ma tra quelle annunciate non ce n’è stata una che veniva invece data per certa: l’integrazione con i servizi di Nuance.

Diverse sono state le feature anticipate dai rumors in rete che hanno trovato conferma durante il keynote di apertura della WWDC lunedì scorso. L’integrazione con Twitter, ad esempio, o un nuovo sistema di notifiche, che abbiamo scoperto dalla presentazione di Forstall chiamarsi Notification Center. iOS 5 introduce molte novità, ma tra quelle annunciate non ce n’è stata una che veniva invece data per certa: l’integrazione con i servizi di Nuance.

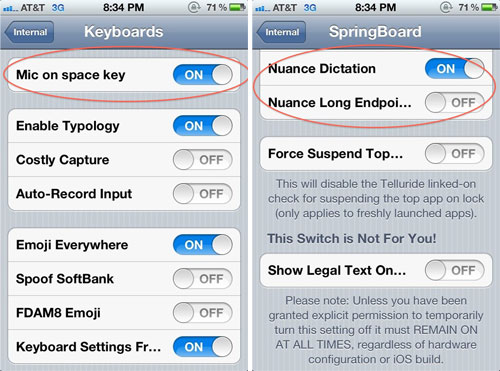

Tra le novità che ci si aspetta di vedere introdotte in iOS 5 c’è anche il riconoscimento vocale. Qualcosa, però, che vada oltre il semplice Voice Control e che permetta, ad esempio, di dettare il testo di un SMS o di un messaggio di posta elettronica ad iPhone per vederlo poi scritto sul display. A questo proposito si era vociferato nei giorni scorsi del possibile accordo che Apple avrebbe stretto con Nuance, compagnia specializzata nel riconoscimento vocale, già dietro ad applicazioni come Dragon Dictation. Nonostante si tratti di semplici indiscrezioni, l’ultima Developer Preview di Mac OS X Lion rilasciata agli sviluppatori lascia intuire che le voci potrebbero essere fondate.

Tra le novità che ci si aspetta di vedere introdotte in iOS 5 c’è anche il riconoscimento vocale. Qualcosa, però, che vada oltre il semplice Voice Control e che permetta, ad esempio, di dettare il testo di un SMS o di un messaggio di posta elettronica ad iPhone per vederlo poi scritto sul display. A questo proposito si era vociferato nei giorni scorsi del possibile accordo che Apple avrebbe stretto con Nuance, compagnia specializzata nel riconoscimento vocale, già dietro ad applicazioni come Dragon Dictation. Nonostante si tratti di semplici indiscrezioni, l’ultima Developer Preview di Mac OS X Lion rilasciata agli sviluppatori lascia intuire che le voci potrebbero essere fondate.

In un post di qualche giorno fa vi abbiamo parlato della possibile trattativa in corso tra Apple e Nuance affinché l’azienda di Cupertino possa utilizzare la tecnologia avanzata per il riconoscimento vocale messa a punto dall’azienda di Burlington, MA, USA.

TechCrunch torna a parlare di questo argomento molto delicato per il futuro di iOS dopo aver indagato un po’ più a fondo sulla vicenda e aver scoperto che Apple potrebbe già utilizzare la tecnologia di Nuance all’interno del mastodontico Datacenter (pronto ma non ancora inaugurato ufficialmente) situato a Maiden, North Carolina. La partnership tra le due aziende potrebbe essere annunciata fra meno di un mese durante la WWDC (questo aspetto farebbe pensare che per gli sviluppatori potrebbero arrivare nuove API per sfruttare il sistema di riconoscimento vocale in qualunque app).

In base a quanto riportato da TechCrunch, Apple potrebbe essere in trattativa con Nuance per avvantaggiarsi del sofisticato sistema di riconoscimento vocale sviluppato dall’azienda nel prossimo aggiornamento del sistema operativo mobile iOS 5.

La notizia era stata messa in circolazione da una dichiarazione poi corretta da Steve Wozniak (forse in realtà aveva detto qualcosa che non avrebbe dovuto?), il quale sosteneva che Apple era in trattativa per l’acquisizione di Nuance. Woz, successivamente, era tornato sui suoi passi correggendo Nuance con Siri (effettivamente acquisita da Apple ad aprile 2010).

Una buona notizia sul fronte del riconoscimento vocale per Mac OS X. Ieri, infatti, è stato rilasciato un comunicato stampa ufficiale da parte di Nuance nel quale è stata annunciata l’acquisizione di MacSpeech, per una cifra non ancora resa nota.

Per chi non ne fosse a conoscenza, ricordiamo che Nuance Communications è l’azienda che ha sviluppato Dragon Dictation e Dragon Search per iPhone, aggiungendo la funzionalità di dettatura vocale. MacSpeech, collocata nello stesso settore di Nuance, ha iniziato la sua attività con iListen (che nel 2008 è stato sostituito da MacSpeech Dictate), a quel tempo unico software per il riconoscimento vocale che permetteva la dettatura su sistemi Mac dopo ViaVoice di IBM. Nonostante MacSpeech Dictate (che utilizza Dragon come motore di riconoscimento della voce) sia stato un grande passo avanti rispetto ad iListen non ha mai raggiunto lo stesso livello di qualità e di funzionalità del rivale Dragon per piattaforma Windows.

Continuano a farsi largo voci riportanti le nuove e incredibili funzioni dell’iPhone OS 3.0 grazie alla bravura e alla determinazione di alcuni che stanno spulciando tutti i files compresi in questo nuovo firmware che per ora è ufficialmente usufruibile dai soli sviluppatori. Secondo le ultime voci raccolte, il nuovo iPhone OS 3.0 conterrebbe l’evidenza di una futura funzione di sintesi e riconoscimento vocale: un altro passo avanti per il melafonino nei confronti di altri dispositivi (come quelli di Nokia) che già da tempo contengono questo tipo di tecnologia. Sembra però che queste nuove funzioni (nome in codice Jibbler) non si limiteranno alla sola possibilità di farci telefonare senza mani: potrebbero essere a disposizione di tutti i developers così da creare applicazioni impensabili fino ad ora.

Un nuovo brevetto depositato dagli ingegneri di Cupertino nel mese di Settembre dello scorso anno (che riporta, tra gli altri, anche il nome di Tony Fadell tra gli inventori) svela i progetti futuri di Apple riguardo l’inserimento di sensori biometrici nei dispositivi hardware con la mela.

I sensori biometrici permettono, facendo riferimento a impronte digitali o scansione della retina, di riconoscere l’identità di un soggetto (presumibilmente il proprietario del device) e di cosentirgli, o meno, l’accesso a un determinato dispositivo.

Con un lieve ritardo, dovuto forse a qualche modifica dell’ultima ora, è finalmente arrivata la